Inteligencia Artificial

La evolución de la IA no sería un peligro para la humanidad

La investigación futura debería centrarse en otros riesgos, como el potencial de la IA para generar noticias e informaciones falsas

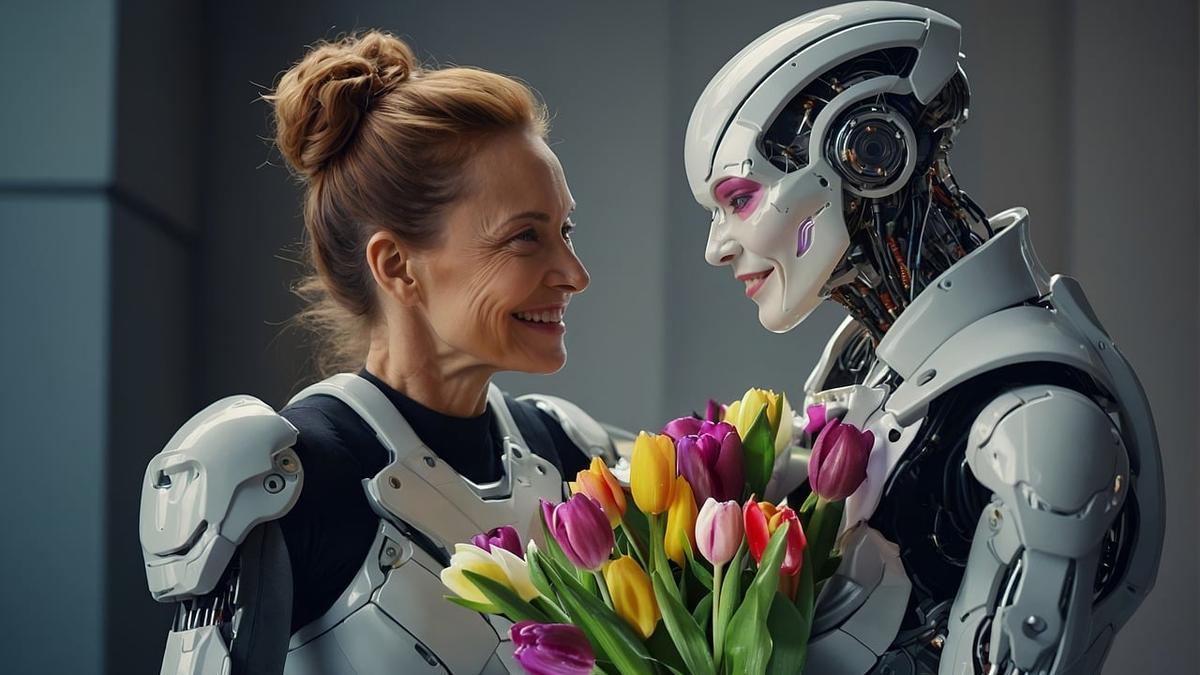

La humanidad no estaría amenazada por el desarrollo de la IA, por lo menos dentro de los parámetros conocidos hasta hoy. / Crédito: Gerd Altmann en Pixabay.

La ciencia ficción y últimamente algunos estudios científicos han planteado que la Inteligencia Artificial (IA) podría ser peligrosa para la humanidad si alcanza una determinada capacidad de razonamiento independiente. Sin embargo, una nueva investigación concluye que en realidad ese peligro no existe: los científicos sostienen que los modelos de IA como ChatGPT son menos capaces de aprender de forma independiente de lo que se suponía hasta hoy: sus habilidades emergentes están limitadas a un aprendizaje de contexto.

Según un nuevo estudio liderado por especialistas de la Universidad Técnica de Darmstadt, en Alemania, y la Universidad de Bath, en el Reino Unido, no hay evidencia hasta el momento de que los modelos de lenguaje grande (LLM) de Inteligencia Artificial (IA) estén comenzando a desarrollar una "inteligencia superior o general" que les permita proceder de manera planificada o intuitiva y pensar de manera compleja e independiente, convirtiéndose en un potencial peligro para la humanidad.

Aún lejos de equiparar o superar a la inteligencia humana

De acuerdo a una nota de prensa, los autores del estudio han llegado a la conclusión de que no hay evidencia del presunto desarrollo de un pensamiento diferenciado en los modelos como ChatGPT y otros similares. Los LLM adquirieron la habilidad superficial de seguir instrucciones relativamente simples, pero estos sistemas están todavía muy lejos de aquello que los humanos son capaces de hacer, concluyen los especialistas.

El temor a una evolución descontrolada de la IA que pueda ser un riesgo para la humanidad se sustenta en las llamadas “habilidades emergentes”: el concepto se refiere a que luego de la introducción de los modelos LLM los científicos descubrieron que se volvieron más poderosos al aumentar el tamaño y la creciente cantidad de datos con los que fueron entrenados. A medida que se ampliaron las herramientas, pudieron resolver un mayor número de tareas.

Frente a esto, muchos investigadores pusieron en duda si es posible limitar este desarrollo progresivo, hasta alcanzar un pensamiento independiente y complejo con la denominada Inteligencia Artificial General (IAG), un tipo hipotético de inteligencia artificial que iguala o excede a la inteligencia humana promedio. Ahora, la nueva investigación concluye que no existiría ese riesgo, por lo menos dentro de los marcos del desarrollo tecnológico actual.

¿Habilidades emergentes o en función del contexto?

Los científicos, que publicaron su estudio en arXiv y lo presentaron en la 62a Reunión Anual de la Asociación de Lingüística Computacional (ACL 2024), sostienen que según sus hallazgos las supuestas “habilidades emergentes” de la IA no son realmente emergentes, sino que son el resultado de una combinación de aprendizaje en contexto, memoria modelo y conocimiento lingüístico. En otras palabras, los modelos de IA evolucionan a partir de los nuevos datos ingresados y del crecimiento del contexto disponible para relacionarlos, pero siempre dependiendo de la supervisión humana.

A partir de estas conclusiones, los especialistas creen que es necesario poner el foco en otros riesgos inherentes al desarrollo acelerado de la IA. De acuerdo a un artículo publicado en Science Alert, sostienen que las próximas investigaciones deberían estar centradas en el enorme potencial de los modelos de IA para producir noticias e información falsa, que puede ser empleada por distintos grupos humanos con fines ilegales o para confundir y engañar a la sociedad.

Referencia

Are Emergent Abilities in Large Language Models just In-Context Learning? Sheng Lu et al. arXiv (2024). Aceptado en la 62a Reunión Anual de la Asociación de Lingüística Computacional (ACL 2024). DOI:https://doi.org/10.48550/arXiv.2309.01809

- Un aviso de última hora de la Policía Nacional pone en alerta a media España: cuidado al sacar dinero en cajeros automáticos

- Aviso de la Guardia Civil a toda España: a partir de ahora, no se puede dejar esto en la guantera del coche

- Un comisario de Policía condecorado y con 44 años de servicio: el sospechoso del doble crimen machista

- Badalona prohíbe aparcar en las cercanías de una superficie comercial para ahuyentar a los transportistas ilegales

- La Policía Nacional enseña qué pulsar en tu móvil para llamar a emergencias sin que tu agresor se dé cuenta

- La próxima sequía no será de agua, sino de algo mucho peor: los expertos ya hablan de un regreso a la Edad Media

- Caso Daniel Sancho, en directo: última hora de la sentencia y la condena por el asesinato de Edwin Arrieta

- Guerra entre Rusia y Ucrania: última hora del conflicto, en directo